Cada día me doy unas vueltas por la blogosfera tecnológica y comento lo que me llama la atención con los colegas. Aquí pretendo hacer otro tanto. Algunos de los temas reincidentes serán Tablet PC y e-ink, y ya de antemano espero que los espíritus sensibles no se lleven las manos a la cabeza si con peor o mejor fortuna explico de forma llana algunos de los temas que trate, porque lo que pretendo es que esto no lo lean sólo los frikis, geeks y demás gentuza como yo.

miércoles, diciembre 14, 2005

interpretando conversate.org y digiriendo los efectos de la blogosfera como conversación

Todo esto surge de una curiosidad que les transmití a Palla y a Fernand0. Nos pusimos a hacer pruebas y de inmediato surgió el escollo principal: conversate no aporta una dirección de email propia. De hecho, el email va desde conversate a las cuentas de correo de los usuarios para avisarles de cambios en las conversaciones que tengan abiertas (redundando al feed rss que ofrecen para cada cuenta de usuario), o para invitar a otros usuarios a participar en conversaciones. Sin embargo, si quieres participar no te queda más remedio que hacerlo a través de la interfaz web.

En resumidas cuentas, conversate.org es un sistema de foros muy reforzado, sí, pero que emplea el email y enriquece su uso de forma marginal. No es una mala idea, aunque por lo que se puede ver en las conversaciones públicas tampoco está cuajando demasiado de momento. En cualquier caso, y bajo mi punto de vista, desaprovecha flagrantemente el email.

Ahora, de vuelta a mi interpretación. Lo que me evocó conversate por medio de una lectura diagonal de su faq demasiado rápida era una reinvención/refuerzo del email. La reinterpretación más inmediata consistiría en un frontend web para mailing list que muestre los hilos de conversación anidados. Lo mismo ya existe.

Otra posibilidad sería enriquecer los servicios de un servidor de email (tanto el servidor propio como un servicio que se prestaría a terceras partes, como un man in the middle. Sería exagerado decir que el email está muriendo por su propio éxito, pero lo cierto es que el spam está provocando que la falibilidad del email sea muy superior a la admisible para una herramienta empresarial tan crítica. Este tipo de servicio sería una estandarización del truco que empleamos para cuando queremos estar seguros que un email llega o es recibido: emplear CC a varias direcciones o pedir que se emplee. En este caso, el "servidor de email enriquecido" ofrecería una cuenta de email que recibiera un CC de todos los email agrupables en una "conversación". De esta manera, todos los usuarios involucrados en un intercambio de email podrían verificar si sus respuestas o las de otros han sido enviadas.

La gran ventaja que aportaría este "servidor de email enriquecido" sería la posibilidad de presentar vía web las "conversaciones" organizadas convenientemente por hilos. Si habéis participado en una mailing list concurrida y activa, habréis comprobado una y otra vez lo difícil que puede llegar a ser seguir las intervenciones. Debido al medio, es una experiencia más compleja y limitada comparada con la que ofrece cualquier foro con hilos de conversación anidados, como por ejemplo mi querido barrapunto. Lo que los usuarios podrían consultar sería el desarrollo de cada intercambio colectivo mediante email, convenientemente organizado.

Volviendo a la idea que propuso Luistxo Fernández en webdosbeta, el email, sin tener el relumbrón que tienen (o pretenden tener) las aplicaciones sociales web 2.0, es el software social con más éxito de la historia, uno de los ejemplos de manual de killer application. Sin él, muchos profesionales nos quedamos cojos o peor. Lo malo es que, en los tiempos que corren, es fuente permanente de frustraciones y cabreos, no por el servicio en sí mismo sino por su inseguridad. Esta idea que lanzo de "servidor de email enriquecido" (si es que alguien no la ha tenido ya) podría contribuir a relanzar el email como software social a nivel empresarial y comunitario.

Por último: no encuentro la referencia de un post sobre web 2.0 e ideas. Lo que venía a decir es que si pretendes lograr algún éxito, tienes que guardar con celo tu idea hasta que la puedas lanzar al mercado con un mínimo de madurez. Nadie debe saber nada hasta que sea el momento. Bueno, en principio no pretendo crear ninguna startup con este concepto (no ha lugar); más allá, creo que este modelo mencionado de altisimo-secreto-para-evitar-que-te-copien no acaba de encajar en nuestros días. En primer lugar, la originalidad es cada vez más difícil y limitada: seguro que tu parida se le ha ocurrido a alguien antes, se le está ocurriendo ahora o se le va a ocurrir en breve. En segundo lugar, obvia la potencia de la idea de la blogosfera (e internet, por extensión) como conversación: la velocidad y riqueza de la interacción e intercambio entre los interesados en un tema dado entra en sinergia y obvia en parte la intervención individual y específica. Más que una intervención brillante que propaga enormes ondas de choque conceptuales, lo que importa son las ideas menos llamativas, lanzadas por millones, leidas, digeridas, reformuladas y que acaban desembocando en las mentes de cada participante en resultados diferentes. Si se entiende, sería algo así como espermatozoides que, en vez de fertilizar un único huevo, se recombinan entre sí para confluir en un gran número de huevos imprevistos.

Y lo mismo me estoy columpiando alegremente y ya existe algo igual o mejor que la idea del "servidor de email enriquecido". Si es así, agradecería que se comentase.

martes, diciembre 13, 2005

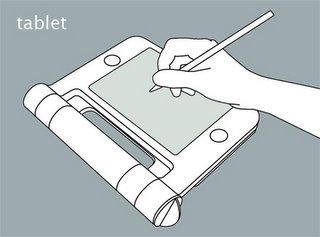

Tablet PC y unidades ópticas

Este post es un fork de un post anterior porque mi mujer dice que había que separarlos y yo, bueno, no he tenido argumentos que rebatieran lo que decía.

Cuando adquirí nuestro toshiba portegé m200, pensé que no tener una unidad óptica era una buena idea a cambio de reducir tamaño y peso. En unos días os diré si ha sido una idea tan buena o no, porque windows XP Tablet PC Edition está diciendo que hasta aquí hemos llegado y hay que reinstalar. A la política bizarra (y criticada por todos los tabletistas) de microsoft de no distribuir una copia del cd de instalación sino sólo un cd de recuperación que obliga a formatear el HD, se une las ideas del siglo XX de toshiba: o te compras una unidad óptica externa por 350 lerus, o un duplicador de puertos por 200. Confiando en que XP ha durado casi un año, creo que voy a tirar de una instalación en servicio técnico por 45 euros, pero ya veremos cómo acaba el tema y si tinta-e se transforma temporalmente en el diario de un calvario técnico-burocrático o no.

Espero no tener que recular y admitir que no disponer de una unidad óptica fue una mala idea.

En cualquier caso, también me he dado cuenta que la política bizarra de MS de no ofrecer un disco de instalación de verdad de Windows XP tablet edition puede tener cierto sentido: Con un disco de instalación estándar no puedo añadir todo el software de toshiba que actúa en concierto con winxp tablet edition para mejorar la experiencia de usuario. Y la mejora, como lo hace tb el equivalente de Acer. Eso me lleva a pensar que tablet se lanzó un poco demasiado pronto para la situación en su momento de microsoft. O no fue demasiado pronto, pero el esfuerzo fue demasiado moderado. O ambas.

el fin del talon de aquiles de los tablet pc

El talón de aquiles de los tablet pc convertibles es su visagra. La de mi máquina es estándar: razonablemente estable, pero sujeta a roturas si no te andas con ojo y cambias el formato de la máquina con un movimiento suave. Por más que haya criticado los tablet Acer por su peso, estamos trabajando con uno para nuestro proyecto de implantación de tablet pc para mejora de la comunicación docente (uno, dos, tres) y puedo decir que la bisagra es mucho más sólida que la estándar en los modelos convertibles (con la excepción, quizás, del incomprensible HP TC4200). Huelga el decir que los modelos slate (como el motion computing LE1600, mi preferido) no tienen problema de bisagra porque carecen de ella, pero en ocasiones eso también supone un problema (cuando quieres escribir encima de las piernas, por ejemplo).

En cualquier caso, los tablet PC se resisten a desaparecer y hasta se diría que avanzan a ritmo de caracol. Acer es un fabricante con una imagen asociada de productos baratos y básicos, y creo que, tras el primer experimento con tablet, han incorporado definitivamente esta línea de productos y se han lanzado a la innovación (al contrario que HP, de momento -- Lo de incomprensible en relación al viene de la decisión de sustituir el rupturista y genial TC1100 por en TC4200, mucho más conservador y anodino.). No es imposible que el mecanismo de giro de los tablet convencionales dé miedo y eche para atrás y, de hecho, es su punto débil, el lugar que lamentan los poseedores de tablets rotos.

Hace 1 mes Acer sacó su nueva línea C200. Aquí podéis ver un extenso comentario. Aparte de aligerar respecto a la línea C300 (cuyos 3,2 kg, puedo decirlo, son muchos cuando se usa de pie), han reinventado el mecanismo de cambio de modo portátil a modo tablet con brillantez, como podéis ver aquí.

De momento, creo que es posible que Acer haya dado en el clavo con este mecanismo, puesto que no es otra cosa que romper con la disposición heredada de los portátiles tradicionales (bisagra en canto) y adaptada lo mejor posible a las necesidades de los tablet PC.

llamar a movil desde Skype o el Güevo de colón

Mi padre y su hermano mayor están superando juntos la brecha digital. Todo comenzó hace año y medio, cuando visité a mi tío en Uberlandia (Brasil) y le estuve hablando de lo bueno que sería para él poder comunicarse con sus hermanos con email o chat. Tanto le motivó el asunto que se apretó el cinturón --es jubilado con pensión brasileña-- y se compró un ordenador.

Mi padre y su hermano mayor están superando juntos la brecha digital. Todo comenzó hace año y medio, cuando visité a mi tío en Uberlandia (Brasil) y le estuve hablando de lo bueno que sería para él poder comunicarse con sus hermanos con email o chat. Tanto le motivó el asunto que se apretó el cinturón --es jubilado con pensión brasileña-- y se compró un ordenador.Mi padre, por su parte, trataba hasta entonces al PC de su casa con digna indiferencia: él en su lugar (su sillón) y el PC en el suyo (despacho). Los dos se pusieron primero con messenger, y ahora con skype. Antes hablaban cada dos meses por el coste, y ahora hablan casi todos los días más de una hora. Mientras que mi tío navega con cierta soltura, mi padre usa de momento el ordenador como vía de acceso a skype. Eso va a cambiar, aunque ha obtenido un triunfo personal al disponer de un micrófono + auricular bluetooth y poder permanecer en su sillón.

Hoy mi padre no ha hablado con su hermano porque tenía un curso de office (una cosa lleva a la otra). Mi tío es bastante despistado y se le había olvidado, con lo que me ha llamado a la oficina con skype para preguntarme por mi padre. Yo he llamado a mi padre por móvil para preguntarle, y de pronto he tenido una pequeña iluminación.

Lo que véis no es un micrófono roto sino uno plegable. Aproveché esta circunstancia para acercar al máximo el micrófono del teléfono al auricular del móvil y viceversa, y así mi padre habló un par de minutos con su hermano a coste de llamada local de móvil. Me ha parecido comparable al güevo de colón.

Esta imagen, a su vez, me ha hecho reflexionar: ¿Por qué gastamos dinero en teléfono los que tenemos conexion de banda ancha a internet? De hecho, es más que posible que me abra una cuenta en Skype Out, pero lo que me parece significativo es que, de momento, no haya sido para mí un automatismo tirar de skype en vez de móvil. Cualquiera diría que la gratuidad sería un incentivo más que de sobra para aumentar el uso de la VoIP, pero las costumbres arraigadas se resisten con éxito a la racionalidad económica.

De hecho, la implantación de la VoIP puede ser un indicador buenísimo de la brecha digital, pues su adopción implica la digestión e identificación de conceptos centrales de la vida digital para el usuario final. ¿Vida digital? Bueno, por decir algo, por llamar de forma corta al lado bueno de la brecha digital

miércoles, diciembre 07, 2005

Unos días sin escribir por culpa del Call of Duty 2

COD2 es un juego "casual", en el mal sentido del término. En nivel 2 de 4 (para paladear), es un mata-mata con gráficos alucinantes, pero sin ninguna sensación de dificultad o peligro. El problema es la elección del sistema de salud: en vez de usar las cajas de salud de toda la vida, con el problema que suponen para encontrarlas y aprovecharlas, en COD2 te hieren como en doom, causandote poco daño, y sólo si recibes varios pildorazos en muy poco tiempo empiezas a estar malherido... hasta que descansas, y te recuperas automáticamente. Teniendo en cuenta que la cosa va de 2ª GM, pues no pega manejar un M1 o un Stg44 y brincar por los escenarios, poniendote detrás de una pared si te han "malherido" hasta que te pones "bueno".

Pero sea como fuere me ha enganchado. ¿Cómo? No como experiencia de juego (me están esperando en mi anaquel varios comprados a precio de rebaja, mucho más realistas), sino como experiencia de "cine interactivo", entrecomillado por mi inseguridad a falta de un término mejor. Salvo un par de momentos que la cosa se pone un poco dura, no es un reto ni mucho menos. Sin embargo, y para un servidor que ya no está en la actualidad de los juegos, el alucinante entorno en 3D y la construcción del desarrollo (como un guión de cine, de una escena a otra), te sumerge bastante bien en una vivencia de la segunda guerra mundial.

Eso sí, como experiencia social, lo único que vale la pena es que lo comparto con los colegas. Pero chirría bastante ver a un fornido soldado rojo saltando como el cordobés por las ruinas de stalingrado.

jueves, diciembre 01, 2005

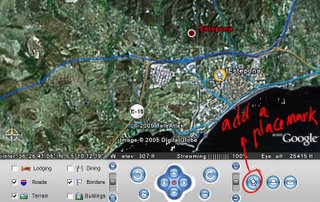

placeopedia, mashup de googlemaps y wikipedia

Más allá del programa original, el valor añadido lo aportamos los usuarios. La comunidad de Google Earth (antigua comunidad de keyhole, el fabricante de Google Earth) reúne una vasta cantidad de información geolocalizada. La indulgencia con los errores de localización puede resultarnos muy positiva, en tanto que, de cualquier forma, contaremos con una gran cantidad y variedad de información geolocalizada. En la imagen podéis ver una captura de una parte del centro de Madrid, con referencias a espacios culturales y monumentos, locales de copas, el cementerio de la Almudena, la casa de un tal Diveke, etc. En otras palabras, sobre un servicio (de momento) gratuito, los usuarios han añadido nuevas capas de información que enriquecen el uso de ese servicio. Todo hay que decirlo, hay que ser un poco selectivo a la hora de visualizar hitos, o se comen la pantalla que da gusto

Google community, por lo tanto, es una funcionalidad 2.0 que aporta un valor social a google earth por medio de una acción de marcado comparable (que no igual) al tagging y que tiene como resultado un repositorio colectivo de información.

Wikipedia no necesita ser presentada, a estas alturas. O bien buscamos información directa en ella (con su buscador o, por mentar otra opción, por medio de algún plugin de búsqueda para firefox en Wikipedia), o bien saltamos dentro de su muy densa red de hiperenlaces, de un artículo a otro, motivados por la curiosidad y ampliando el conocimiento sobre un tema genérico a partir de estos post individuales.

Placeopedia es un mashup que le da la vuelta al concepto de Google Earth community. En principio puede pensarse que no tiene demasiado sentido georreferenciar los post de la wikipedia, cuando muchos de ellos ya tienen sus mapas e información geográfica integrada. El asunto se pone interesante si pensamos tanto en los beneficios que obtenemos recorriendo las marcas de Google Earth Community como la estructura de hipervínculos de wikipedia: acceder a información adicional potencialmente interesante a partir de una primera información que hemos buscado.

Con placeopedia, por lo tanto, el usuario puede volar sobre la información georreferenciada como lo hace encima de las ciudades y campos satelitales de Google Earth. La "sabiduría de las multitudes" (aquí, un muy interesante post sobre su dueño) se aplicaría al cuadrado, puesto que sería la comunidad de placeopedia la que posicionaría y destacaría los contenidos creados por la comunidad de Google, pudiéndose constituir en algo así como un populicio.us (un del.icio.us popular) de la información recogida en la wikipedia.

Lo que me parece elegante y sugerente es que podría calificarse este mashup como "metasocial": siembra una pequeña comunidad, solapada con una parte de los editores de wikipedia, para georeferenciar los artículos de la misma. Si para el visitante de placeopedia el beneficio es evidente, entiendo que el georreferenciador ayuda a posicionar/visibilizar el artículo específico que le interesa.

Tres conclusiones personales:

a) estaría muy bien mashupear la wikipedia referenciando los contenidos que se crearan o consultaran por medio de geourl estándar o populares (lo mejor, creo, la notación decimal de longitud/latitud)

b) la wikipedia es una enorme suma de artículos referenciados entre sí. Presenta comportamiento de larga cola, con un núcleo amplio de artículos visitados y, por lo tanto, cuidados y reeditados las veces que haga falta y una larga cola de artículos poco visitados y poco cuidados. No es imposible que esta situación desemboque en que los autores busquen y deseen formas de que sus artículos se visibilicen, y placeopedia y otros mashups podrían jugar algún papel en esto

c) mediawiki podría "mashupearse" otro nivel y posicionarse definitivamente como una de las reinas de la cosa 2.0. Esto es, si ahora es fuente de mashups, podría ser también destino de mashup y, por lo tanto, aprovechar las fuentes de otros espacios y servicios web que hayan liberado sus APIs: un ejemplo sería el uso de googlemaps para hacer más dinámicas y versátiles las informaciones geográficas, comparadas con las imágenes estáticas de mapas que se usan en wikipedia hoy.

martes, noviembre 29, 2005

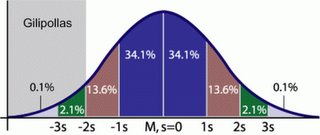

Los gilipollas, la campana de Gauss y la brecha digital

¿A qué huelen las nubes?

Esa pregunta de un publicista inspirado es tan fácil de responder como es fácil de definir la cualidad de "gilipollas". La mejor definición que he encontrado por ahí: la del bushcador.

Cuando la equiparamos con "tonto" perdemos el tiempo, porque para empezar el sentido literal de tonto es casi un arcaicismo. Mi mejor intento, evitando en lo posible la tautología, sería "aquellas personas de inteligencia normal (IQ superior a 81 en una base 100) cuyas ideas, decisiones o elementos de su cosmovisión en general son incoherentes con dicha inteligencia".

El problema se agudiza si consideramos lo altamente imprecisa que es la medición del IQ y, en general, el baremo para dictaminar la cualidad de gilipollas: otros individuos de inteligencia normal, potenciales gilipollas también ellos. No es sólo que en algún momento dado todos hemos tomado decisiones gilipollas sino que, bajo el criterio de otros, nuestra persona puede caracterizarse como gilipollas. Y recordemos que lo de gilipollas va de eso, de criterios.

Una variación interesante viene de un idioma que tiene a bien definir a los gilipollas. En hebreo, fraier (פרייאר) es aquel ser humano crédulo, que hace todo según las normas, que no se salta jamás las reglas, etc. Entre los israelíes, existe una preocupación muy seria por no ser ni parecer fraier.

Sinteticemos: todos nos comportamos alguna vez como gilipollas, pero el gilipollas esencial, ontológico y de antología, está en el lado malo de la campana de Gauss: de μ -2 a la derecha.

La combinación de mi definición y la definición de fraier puede ser útil para analizar el comportamiento de ciertos comerciales de los que hablé ayer.

En efecto, esos comerciales no formados en TIC, que venden humo a diestro y siniestro (como hacen mis primos, tal para cual aunque no son lo mismo porque el comercial, en algún sentido, trabaja), se mueven bajo una definición de gilipollas bastante diferente.

vender humo ~ vender motos ~ vender la burra... entiendo que no es posible vender "cualquier cosa" a "cualquiera" sin identificar a tu interlocutor como "gilipollas" (o "primo", en sus términos). Para maximizar las ventas, claro está, el no-gilipollas tiene que ser la excepción.

Supongamos que coincidís con mi definición de gilipollas esencial (μ -2). Si estos comerciales siguen existiendo, algo falla, ¿no?

¿Cómo podemos explicar, en otras palabras, que los clientes de estos comerciales compren productos que no necesitan, o que no hacen lo que necesitan? Dicho de otro modo: aquellos clientes de estos comerciales que no caen dentro de la categoría de gilipollas esencial, ¿hacen el gilipollas cuando firman una venta?

Yo diría que no necesariamente.

Es cierto que estos comerciales patológicos tienden a tener ciertas habilidades dialécticas ante las que nadie es invulnerable en un momento dado. Todos tenemos un día tonto o, como se indica líneas arriba, todos podemos hacer el gilipollas en un momento dado.

Más allá de esto, creo que el problema fundamental es la brecha digital. La brecha digital ni tiene que ver con la dimensión ocasional ni esencial de "gilipollas": es una característica diferente de los individuos y las comunidades, mucho más reciente... y de repercusiones más severas.

El potencial cliente de estos comerciales trabaja en un entorno en el que la ventaja productiva de las TIC es un hecho completamente consumado. Por diversos motivos, muchos de estos potenciales clientes están en el lado malo de la brecha digital: carecen de la información y conocimiento adecuados para tomar decisiones óptimas sobre productos o servicios TIC. Se enfrentan a un dilema: o comprar lo que no necesitan, o no comprar lo que podrían necesitar, porque "yo no soy un [gilipollas|primo]". En ambos casos, las consecuencias de su decisión son perjudiciales.

El problema de España es que si el gilipollas esencial está en μ -2, la población que está en el lado malo de la brecha digital es significativamente más numerosa. Los directivos, funcionarios y profesionales con poder de decisión, tienen su cuota de representación en "el lado malo de la brecha digital". El efecto combinado y acumulativo de sus decisiones es mucho más importante que todo lo que el Estado pueda hacer o dejar de hacer de cara a la situación de la brecha digital en España.

Y de momento no se me ocurre ningún remedio. Si como veíamos ayer, muchos barrapunteros se quejaban de que el comercial vendehumo era mucho más valorado que el desarrollador, a la fuerza tiene que estar relacionado con la brecha digital. En mi opinión, todos los lamentos de ayer, y muchos otros, nos hablan de un país con un sector de desarrollo y servicios TIC en el límite mismo de la viabilidad, algo que no puede cambiar sólo con iniciativas del Estado. Es el zeitgeist de nuestro país, un problema fundamentalmente cultural e idiomático. Un problema que, ante todo, necesita concienciación.

lunes, noviembre 28, 2005

Rebelión de los informáticos en barrapunto

Una noticia de businessweek (comentada en dirson) ha montado un interesante diálogo en /.. Y digo diálogo porque no hay debate, no hay posiciones encontradas sino claridad... en la base.

En efecto, la noticia original, en su contexto inicial, comenta con extrañeza (si no con alarma) que los comerciales y businesspeople en general son ciudadanos de segunda en Googleplex, mientras que los ingenieros y técnicos tienen una mayor consideración dentro de la empresa, en la cultura corporativa y a la hora de la toma de decisiones (en cada escalón, imagino). Se pregunta vplabs:

No quiero analizar esto en términos del siglo XX (reivindicaciones, ideologías) sino en términos del siglo XXI, que por cierto no sé cuáles son. Sin embargo, si todo parece indicar que la actividad sindical (al menos, en este país) no tiene sentido en el sector de las TI, puede que a medio plazo ocurra lo impensable y el comercial deje de tener la preponderancia que tiene ahora. Un pobrecito hablador comenta que:¿El escándalo está tal vez en que el sistema se ha corregido? Es decir, que el ingeniero allí no es el pringado pateado, sino que goza de cierta consideración.

¿Allí se han dado cuenta de que el trajeado es sólo eso, un trajeado? Es decir, alguien que cuida su imagen porque tiene que vender imagen, ya que no puede vender producto.

¿Les escandaliza que cobren más los ingenieros que los financieros? Yo llevo mucho tiempo viendo financieros que en ocasiones cobran el doble que ingenieros desarrollando excelentes productos.

Aqui por ejemplo, siempre ha funcionado, aunque al reves, el tecnico es el ciudadano de tercera categoria, y el vendedor es "el puto amo", aunque venda los productos generados por los primeros. De todas maneras, se ha encontrado la solucion a este problema, puliendose todas las empresas que generaban productos nuevos, vendiendolas o desmantelandolas y convirtiendonos en un pais de servicios, asi ya no hacen falta tecnicos, todo llega listo para vender desde el extranjeroMuchos de los que leéis esto conocéis en vuestras carnes o en carnes ajenas los motivos completamente reales que hacen al PH posicionarse así. Sin embargo, si no llevamos su posición hasta el fatalismo, podemos pensar en un futuro distinto.

Hasta ahora, los límites de la comunicación hacían todopoderoso al contacto personal: la persona con buen aspecto y labia, que franqueaba las barreras de los directivos de empresas e instituciones potenciales clientes de la suya. Todos conocemos el espectro de recursos a su disposición: desde los blancos (su carisma, un detalle a tiempo, la atención cuidada) a los negros (coimas, servicios sexuales, etc.).

Sin embargo, la velocidad de los cambios puede terminar dejando atrás, si no a la figura, al menos sí a su faceta de esperpento: al comercial que le da igual 8 que 80, porque no entiende nada de lo que está vendiendo. Como trataré en un post próximo, el problema es que esto funciona a pelo con los que están en el lado malo de la campana de Gauss: los gilipollas. Para el resto, de sigma -2 a la derecha, pues como que no.

Con el ritmo que está llevando el cambio tecnológico y el sector TI en general, una empresa normal con deseos de sobrevivir necesita tomar decisiones informadas y protegerse contra el que vende humo. La época dorada del consultor ya terminó, y esta política de Google puede ser una avanzadilla de los tiempos por venir.

Y acabo. No quiero quitarle el protagonismo a lo que ha capturado mi atención como tantas otras veces: a la comunidad de práctica (una definición en castellano salvable) de barrapunto en acción. Como tantas veces --¡si la relación señal/ruido es buena, claro!-- el diálogo entre barrapunteros ha puesto en marcha mis sinapsis y he obtenido un beneficio intelectual. No sé si a esto se le puede calificar como de freerider o no (posiblemente la respuesta esté en esta discusión de la wikipedia). En cualquier caso, me resulta desde hace años una ventaja competitiva, porque una y otra vez me ha inspirado para innovar dentro de mi empresa.

technorati tags: collectiveintelligence, inteligencia colectiva, inteligenciacolectiva.

viernes, noviembre 25, 2005

más sobre OLPC, el portátil de 100$

El 17 de noviembre de 2005 puede que sea una fecha histórica para la humanidad. Negroponte y su equipo del MIT presentaron el primer prototipo funcional de su idea, One Laptop Per Child, también conocido como "el portátil de 100$", del que ya he comentado algunos aspectos prometedores.

Si comparáis con las capturas que incluí, del primer proyecto público al prototipo actual han cambiado algunos aspectos. Para empezar, es verde y, según Negroponte, "ha sido la decisión más difícil que han tenido que tomar" (sic), y el motivo ha sido "[transmitir] un mensaje de disfrute y diversión".

Si en el post anterior comentaba que el problema técnico más espinoso iba a ser la pantalla, en este artículo se relata una breve historia de la misma. De hecho, es la historia de cómo Mary Lou Jepsen fue abducida por Negroponte para que aportara su concepto de pantalla barata y de muy bajo consumo (35$, retroiluminada por LEDs) y se convirtiera en la directora de tecnología del consorcio OLPC. Podéis escucharla (a duras penas) en su arrebato de conversa aquí. Por otra parte, la duración de la carga con 1 minuto de darle al manubrio está en 30 minutos, ya no tan lejana al objetivo de una hora.

Sólo el simple hecho de que funcione con Linux puede ser una causa de que finalmente no tenga éxito. Un éxito relevante sería una amenaza directa contra Microsoft, por un lado, y contra los grandes fabricantes, por otro. El peligro para los segundos sería mayor, porque pondría sobre el tapete lo innecesario de las capacidades de los portátiles para muchísimos usuarios.

Otro motivo para que no funcione es el peligro de la mesh network que se ha pensado que los equipos establezcan entre si. Realmente, OLPC es un caballo de troya o peor, un torpedo contra la línea de flotación de, digamos, la ventaja tecnológica de occidente. Si los equipos llegan a distribuirse en números semejantes a los previstos, en teoría podrían crear redes de telefonía VoIP locales, algo casi más importante que la alfabetización digital strictu sensu. Además, estas capacidades superarían con mucho el entorno docente, permitiendo a comunidades enteras entrar en comunicación con el ancho mundo.

Pero pongamos que funcione. Pongamos que en invierno de 2006 los niños de Brasil, Tailandia, quién sabe si Massachussets, etc., los tienen en sus manos. Una de las esperanzas más fuertes y hasta locas de Negroponte es que los niños aprendan a aprender entre ellos, en incipientes comunidades de práctica, entre otras cosas utilizando un entorno de programación con buenas aplicaciones para niños llamado squeak (1, 2, 3). Podéis ver un ejemplo aquí.

La diversión que menciono en la cita de negroponte es antónima al concepto equivalente que tenemos para un niño occidental: una gameboy, una PSP. El OPLC no tiene prestaciones para eso. Salvando las distancias, se parece mucho más a un spectrum.

Si el spectrum fue para muchos de nosotros lo que fue, un reto desde que abrías la caja, un campo limpio para sembrar con trabajo y recoger nuestros frutos, imaginaos lo que pueden ser millones y decenas de millones de "spectrum on steroids" conectados inalámbricamente y en manos de chavales con un incentivo aún mayor que el nuestro para aprender.

Technorati tags: digital divide, OLPC

miércoles, noviembre 23, 2005

El correo se puede convertir en conversación

En webdosbeta, Luistxo Fernández comentaba que con tanto rollo con web 2.0 se estaba dejando de lado al email y, además, a las listas de correo, las primeras plataformas de comunidad junto a las BBS. Y no le faltaba razón. El problema del email no es sólo el spam, sino que ya no es in. Estética y conceptualmente, es el polo opuesto de las aplicaciones web enriquecidas, de los mashups, no se le puede añadir tags... aunque gmail esté desarrollado en AJAX.

Al email le queda mucha cuerda. Nadie ha encontrado un sustituto para una plataforma de comunicación de sus características, y además está completamente implantado e interiorizado tanto entre empresas como dentro de intranet. El email, además, sigue siendo una importante fuerza social: desde el incombustible correo-cadena (que demuestra la cantidad de tiempo que tienen algunos y el carácter infinito de la credulidad), pasando por las listas de correo, los boletines (como CRYPTO-GRAM, mi preferido)...

Como algún día comentaré, la sustitución que hice del email por un wiki para gestionar el flujo de cuadernos de campo en proyectos de investigación etnográficas fue un salto de seguridad y coordinación drástico. Casi parece una de esas comparaciones de O'Reilly: email(web 1.0) / wiki (web 2.0).

El error puede estar en considerar antagónico lo que no tiene por qué serlo. Si el puntal más importante de cosa 2.0 es la dimensión social, la comunidad, la inteligencia colectiva, la larga cola y demás, el email tiene perfecta cabida en este cambio prometido.

Así lo han visto los responsables de conversate.org. Lo que te ofrece este servicio es encauzar los email que necesites dentro de una "conversación". La ventaja inmediata es que se introduce una redundancia en el intercambio: como los email quedan registrados en la plataforma, puedes recurrir a ella si por el motivo que sea el email no ha llegado. Más allá, la aportación fundamental es la de introducir orden en el email.

La única manera efectiva de mantener el hilo de intervenciones con el correo es ir dejando una cola detrás compuesta por los email anteriores. Tiene unos límites obvios que se acentúan cuando escriben más de dos personas. Lo que aporta conversate.org es reunir los email de forma temática y organizar las sucesivas respuestas de forma anidada, igual que ocurriría con un foro (e.g., los hilos de respuestas en barrapunto, por si alguno no conoce (!?) el sitio, incluyo un post reciente que me ha interesado especialmente para ilustrar este punto).

Esta ventaja, que hace posible seguir un post con cientos de intervenciones en espacios así organizados, se explota aún más con la posibilidad de que los intervinientes puedan invitar a quien les apetezca, o abrir la discusión a otros usuarios, o dejarla cerrada. En cualquier caso, las ventajas principales son las que buscaba en principio cuando introduje nuestro wiki, allá por 2002: seguridad y coordinación. Para lo que lo usamos en mi trabajo, el wiki sigue manteniendo su ventaja, pero si esto hubiera existido me habría hecho dudar.

Por no alargarme demasiado, sólo me detendré en que este sistema permite aumentar la resistencia al tiempo de los email. Tanto la organización en "conversaciones" como el hecho de residir en un servidor web permite que los hilos de conversación puedan seguir siendo consultados con más facilidad pasado un tiempo.

Dos pinceladas finales: a) en cierto sentido, es lo que google ofrece a nivel individual dentro de su gmail, pero trasladando el concepto de conversación a una dimensión colectiva. b) la ventaja potencial más importante es que ofrece distintas posibilidades para potenciar y privilegiar la dimensión social del email... incluso podría lograr, de triunfar, que el email dejara de estar demodé.

technorati tags: web2.0, socialsoftware, collectiveintelligence, inteligenciacolectiva,

martes, noviembre 22, 2005

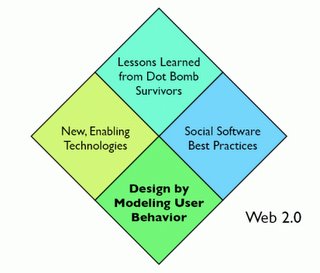

Una presentación divulgativa y discutible sobre web 2.0

Como he venido diciendo últimamente respecto a la cosa 2.0, ni quito ni pongo rey, o no creo en las brujas pero haberlas, haylas. Sigo en la duda, vamos, y creo que hay algo entreverado con vapor.

Una de las razones más poderosas que tengo para llamar "cosa" a web 2.0 es que no es definible, de momento, en una única frase central. Por otra parte, algunos detractores/descreidos aprovechan este mismo argumento para afirmar que es vapor / y/o una intención ilégitima de querer etiquetar un conjunto de tendencias anteriores.

Honestamente, soy un poco mulder para esto de la web 2.0. Quiero creer aunque, como a muchos, el más mínimo olor a vapor me pone en guardia.

Pues bien, este post divulgativo y, sobre todo, su presentación me empujan a creerme un poco el asunto. Un poco, ojo. Aunque no sea una única frase, lo cierto es que el tipo presenta las ideas de forma menos profética y más llana que O'Reilly. Además de hacer un buen esfuerzo de síntesis, realiza una aportación que me ha llamado la atención:

Diseño con la vista puesta en el modelado de la conducta del usuario. Aprovechar las lecciones de los supervivientes del crack de las dot com e identificar las mejores soluciones de software social mediante la observación de actividades de los usuarios comparables al caso que nos interesa. Una vez identificadas, modelizarlas por medio de las nuevas tecnologías emergentes.Lo de discutible en el título es más literal de lo que parece: para mí la web 2.0 sigue siendo "cosa", algo poco claro y necesitado de discusión desapasionada. Si le echáis un bis a la presentación y el post, es posible que coincidáis conmigo respecto a algún punto sospechoso, demasiado arriesgado o incluso ligeramente vaporoso. En eso no quiero condicionar así que, si os animáis, los comentarios están para meterle cera al tema.

En otras palabras, creo que todo esto de la web 2.0 gira en torno a aprender cómo diseñar sistemas que modelicen el comportamiento de los usuarios. Esta idea es similar a otras precedentes al respecto, incluyendo la idea de O'Reilly de encauzar la inteligencia colectiva y la aportación de John Hagel, creación distribuida, colaborativa y acumulativa.

technorati tags: web2.0, web 2.0, collectiveintelligence, inteligenciacolectiva,

lunes, noviembre 21, 2005

del.icio.us tagrolls

Aún a riesgo de ponerme demasiado didáctico, pero por si alguno no lo conoce, del.icio.us es un servicio web elegantísimamente diseñado que te permite almacenar tus bookmarks, favoritos, o como quieras llamarlos, de forma cómoda y accesible. Esta idea, aparentemente simple, ha resultado toda una revolución para los que nos gusta referenciar las páginas web que vamos visitando, tanto por el hecho de estar en web e independizarnos de cualquier forma local de archivar nuestras referencias, como por usar tags para gestionar nuestras entradas.

En este caso, el "primo tonto de Ozymandias" (porque todos sabemos que Ozymandias es el hombre más inteligente de la tierra), eres tú, lector. De un vistazo, puedes ver buena parte de lo que estoy mirando en internet últimamente y a qué le dedico más o menos atención. En mi caso, se puede ver lo que he creído que merecía la pena referenciar. En el caso de otros, pues depende de cómo hayan pensado a del.icio.us.

Tan gratamente impresionado me quedé con esto de las tag clouds, que decidí aplicarlas a mi curro (sociólogo, por si alguno no ha leído post como éste, con todo mi amor a mis "primos"). Tanto es así, que acabo de aplicar el concepto por primera vez al informe de una investigación. No tengo constancia de que se haya hecho más veces, pero o mucho me equivoco o va a ser un recurso cada vez más frecuente en mi sector. Así ha quedado (aunque, por buenas prácticas, no revelo tema ni cliente :) ):

El otro aspecto que me llama la atención, y del que me barrunto que sólo hemos visto el principio, es la adquisición por parte de los blogs de nuevas características vía mashup con otros servicios web. Si aquí véis una incorporación de del.icio.us, en el blog de Enrique Dans podéis observar la incorporación de un mashup de flickr, y la gente de Tagzania nos explican cómo colocar un mapa de los que se pueden construir con tagzania a partir de Googlemaps (un mashup de un mashup, por así decirlo).

Yo sigo empleando el término "cosa 2.0". No tengo claro si se va a generalizar o no la incorporación de mashups en los blogs actuales. En cualquier caso, me tienta pensar que esta faceta de la cosa 2.0 de "servicios débilmente unidos" termine por ayudar a los usuarios a pensar en sus aplicaciones de aún más distintas de lo que ya lo hacen, a dejar a un lado las categorías estancas de plataformas web para llegar a configuraciones de mis servicios web que se vayan adaptando a lo que tengo en la cabeza y no al revés.

blogs adquiriendo facetas de mashups: del.icio.us, flickr, googlemaps...

viernes, noviembre 18, 2005

para mañana

La verdad es que la tengo ganas. Otra vez, se trata de analizar la realidad social (española) de Internet... desde fuera. Para qué vamos a probar otra cosa, con lo bien (?!) que funcionan las encuestas a pie de calle o telefónicas.

Como mínimo, os dejo con estas dos perlas impresionantes:

O esta comparación peregrina, que en mi dialecto se identifica con la duda ontológica: "qué tendrán que ver los cojones con comer trigo"... a pesar de que "mail" y "e-mail" se parezcan XDXDXDXD

jueves, noviembre 17, 2005

tagging social y profesional

Llevo unos días atacado y lo que me queda, así que toca ser telegráfico.

Uno de los aspectos más relevantes de la cosa 2.0 es el concepto de folksonomías, algo que traté en su momento y sobre lo que voy a volver a buen seguro.

Por más que sea un concepto apasionante, una posible herramienta básica en el desarrollo de la inteligencia colectiva, me parece que está muy arriba en la brecha digital. Aunque sea un concepto simple, hay que dar dos saltos conceptuales:

- Aplicarlas en provecho propio

- Usar sólas o en combinación las etiquetas ajenas

Las aplicaciones y plataformas que están ofreciendo servicios de tagging están experimentando un crecimiento muy rápido... pero, aún sin datos completamente sólidos, diría que sólo entre los usuarios consolidados de internet. Incluso parece razonable asumir que no todos los usuarios de flickr sacan provecho a las tags, sino sólo su núcleo central de power users.

Lo que me parece especialmente interesante, al hilo de lo apuntado arriba, es que la popularización del tagging puede ser un buen indicador del avance respecto a la brecha digital (no el único, claro, pero sí comparado entre países, entre motivos de acceso a internet, etc.)

En cualquier caso, lo que ha terminado de atrapar mi atención es el hecho de que soy un taggero profesional. Si las folksonomías son el resultado del uso colectivo, incontrolado y útil por mera acumulación de usuarios y tiempo de las etiquetas, existen desde hace 10 años una serie de herramientas CAQDA (Computer Aided Qualitative Data Analysis) que se sirven de una versión mucho más controlada y precisa del principio de etiquetar: el usuario, un analista académico o profesional, reúne sus datos no estructurados (textos -entrevistas, diarios de campo, lo que sea-, fotos -material de campo o archivo, radiografías, lo que sea), y les aplica por medio de la aplicación de su elección distintos códigos para describir el significado específico que para él tiene cada elemento de sus datos. Cuando se lleva un tiempo acumulando trabajo con una herramienta CAQDA, la diferencia de resultados es dramática.

Imaginaos lo que es buscar entre mis cientos de informantes de una base de conocimiento de más de 700000 palabras (algo más de 1500 folios a un espacio), las declaraciones de mis informantes (sin hogar, por poner un caso) conectadas con el uso de los animales de compañía como recurso emocional y como fuente de ingresos. A pelo, artesanalmente, como que no. Estas y otras cientos de preguntas que le hago a mi base de conocimiento cuando analizo, tienen respuesta (ordenada, manejable) en unos segundos.

Una imagen vale más que mil palabras, dicen. Pulsad sobre la imagen para ver la captura a tamaño real.

miércoles, noviembre 16, 2005

Desmitificar las bondades de Skype

Estais muchos como locos con lo de Skype. Desde mi desconocimiento del producto (ni lo he instalado, ni lo he visto funcionando, ni tengo intencion de hacerlo) voy a detallaros algunas caracteristicas tecnicas y/o funcionales que lo afean a priori.

En primer lugar, no le veo el problema a la transmisión asíncrona de archivos.

Me explico: salvo el streaming de audio o video, la transmisión de archivos siempre es asíncrona, ya que hasta que no tienes el archivo completo nada puedes hacer con el (algunos formatos han superado este escollo, como el pdf, que puedes descargar de una web según vas leyendo las primeras paginas). Podríamos decir, casi mejor, que la transmisión de archivos es un hecho atómico: o lo transmites todo o no has transmitido nada (en la mayoría de los casos).

De esta forma, ¿qué más me da ver la barrita en el Skype o el MSN o lo que sea que mandarlo por correo y que el me diga cuando le ha llegado? ¿Que me aporta? ¿Que se cuando le ha llegado? Si estoy en conferencia de texto o voz con el destinatario, ya me lo dirá: 'Como mola esto que me has mandado' '¿Por que me envias fotos tuyas desnudo?'

El problema es el de siempre: Nos puede el ansia y tenemos que estar preguntando cada cinco minutos '¿Te ha llegado?' '¿Te ha llegado?'

Ese hecho es una muestra más de la desconfianza en las nuevas tecnologías, de nuestra mentalidad atrasada. En realidad es el caso típico del que manda un mail y llama por teléfono para confirmar su recepción y lectura.

Por otro lado, cosas que convierten a Skype en un prometedor joven de talento que tendrá una muerte prematura:

1º La curva de aprendizaje. No aporta nada que los usuarios entiendan como innovador o necesario, y les obliga a instalar y aprender a usar un nuevo producto. Respecto a que es mejor y mucho más rápido: El sentir general es que MSN es lento por que las conexiones a Internet son lentas. Su unica baza es jugar habilmente sus cartas de 'no ser de Microsoft'. Respecto a lo de conectar con NAT, Firewalls y demas, MSN puede tambien.

2º El hecho de que Skype guarde solo localmente mi lista de contactos lo elimina de mi lista de candidatos: una de las cosas que mas me gusta de MSN es que allá donde vaya, instalo MSN o uso su versión Web y tengo todos mis contactos disponibles.

3º No puedo evitar convertirme en un supernodo, con lo que mi maquina queda sobrecargada gestionando otras conexiones.

Si quereis mas info sobre Skipe y su protocolo podeis leerla aqui http://www1.cs.columbia.edu/~library/TR-repository/reports/reports-2004/cucs-039-04.pdf.

En definitiva, la unica innovacion que aporta Skype al panorama de IM es que se basa en la tecnologia P2P de Kazaa. Este detalle es transparente para todos los usuarios.

Es importante no confundir 'innovacion' con 'optimizacion'.

Un producto que presenta caracteristicas innovadoras puede desbancar al competidor dominante, siempre que las innovaciones sean acogidas por el publico.

Un producto que tan solo ha optimizado algunos aspectos de su funcionamiento, lo tiene muy dificil para desbancar a nadie. Sobre todo cuando la medicion objetiva de esta optimizacion por parte del usuario es dificil, ya que se ve velada por factores externos como la velocidad del ordenador, la velocidad de la conexion a internet, la pericia del usuario, la distancia geografica... ya sean estos factores agentes reales o tan solo mitos...

martes, noviembre 15, 2005

Velocidad de transferencia de archivos en Skype

A alguno le gustará también el hecho de que todo skype funciona a través del puerto 80 y, por lo tanto, lo de funcionar detrás de un firewall también se aplica.

Cuando no hay un firewall por medio, he comprobado que la velocidad de transferencia de archivos es bastante decente. Esto me ilusionó bastante, porque si funcionara en todos los casos gozaría de una ventaja adicional: no depender del email cuando estás en contacto sincronizado con otros usuarios para intercambiar los archivos de los que estés hablando. Si lo pensáis, tiene cierta lógica: el intercambio de archivos se hace sobre un medio asíncrono (el email) mientras la comunicación es en tiempo real:

"¿Te ha llegado ya?"Como niños de viaje en coche, vamos.

"No"

"¿Te ha llegado ya?"

"No"

Desgraciadamente, por algún motivo que todavía se me escapa los creadores de Skype decidieron no gestionar la transferencia de archivos de forma semejante a la de voz. De esta manera, si estás detrás de un firewall o NAT te puedes encontrar con la bonita sorpresa de que tu transferencia sea delegada. Esto significa que, en vez de tunelarse directamente, los archivos se transferirán pasando por otros elementos de la red Skype. Para que esto funcione, el límite de velocidad se establecerá en 1Kb/s. En su defensa, arguyen que una transferencia lenta es mejor que ninguna, y lo mismo hay un escollo técnico que se me escapa para esta diferencia.

Pero es una pena. Sería todo un salto que la transferencia de archivos pudiera acompañar el ritmo de una conversación sincronizada.

Eso sí, como efecto colateral he comprobado que una cuenta Skype puede estar conectada por varios clientes a la vez. Si eso ocurre, y uno de los clientes acepta una transferencia de archivos, el archivo se transfiere a la vez a todos los clientes. Esto ofrece algunas posibilidades bastante interesantes, ¿no creéis?

lunes, noviembre 14, 2005

Autoperturbación

Todos sabemos lo que es la autosatisfacción (como dirían académica palanca, "el frotar se va a acabar"). Sin embargo, un hecho de la naturaleza menos conocido es la autoperturbación, o la acción de un ser vivo para provocarse molestia a sí mismo y no placer. Lo mismo los etólogos lo tienen más que sabido pero para mí, pobre sociólogo, es una novedad que me ha dejado intranquilo.

Véase

De todas maneras, un video vale más que mil fotos: la situación.

killer portable device(s)

La futurología me da bastante yuyu, entre otras cosas, porque es una de las múltiples ocupaciones de mis primos. A partir de algunos artículos e informaciones fragmentarias de los media y, sobre todo, de lo que dicen otros futurólogos, hacen predicciones que o bien son très épatant (y con suerte nadie los recuerda, gracias a la caducidad buscada de dichas intervenciones) o bien son como las de la pitonisa de Delfos, tan generalistas que siempre van a acertar a menos que no haya futuro: "Triunfaras... no... caerás... en... batalla".

Lo que me produce un acongoje superable es partir de algunas de las tendencias actuales y pensar a corto plazo en sus desarrollos. De ahí el plural en el título.

Podemos comenzar con el concepto de killer application. Estaríamos hablando de aquellas aplicaciones que ponen amplios sectores cabeza abajo. Como indican en el artículo, "aplicaciones tan útiles que serán suficientes por sí solas para que los usuarios adquieran un dispositivo o sistema operativo específico, aunque sólo sea para hacerlas funcionar". Una killer application puede mantener en pie una plataforma minoritaria, como ha ocurrido en España con Apple y la autoedición.

Extendiendo un poco el concepto, una killer application dispara la adopción de un dispositivo y/o tecnología, tal y como ocurrió con los PC, la ofimática, los clientes de correo y los navegadores. Dando la vuelta a la cuestión, podríamos llegar al concepto de killer device, un dispositivo TIC que produzca cambios fundamentales en grandes sectores de la economía y la sociedad.

El PC es un killer device, y también lo es el teléfono móvil. No lo son ni las PDAs ni los Tablet PC.

Un killer device necesitó en su momento de una killer application. Al primero le pueden aparecer más killer applications después de consolidarse, y lo que cambiaría entonces sería la percepción y valor del dispositivo. Un buen ejemplo ha sido la generalización del acceso a Internet: el PC, de ser un dispositivo ofimático ha pasado a ser, también, una puerta de acceso a internet y el email.

En Zonalatina incluyen un buen artículo sobre los roles de la adopción de una innovación tecnológica. Por este orden, serían: innovador, adoptador temprano (early adopter), mayoría temprana, mayoría tardía, furgón de cola. Lo malo es que este modelo funciona si el producto alcanza a un rango de usuarios suficiente.

La PDA se quedó a medio camino entre los early adopters y una mayoría temprana porque careció de nada parecido a una killer application. No lo consiguió con su software central (gestión de información personal, calendario, agenda, tareas), ni con sucesivos intentos, tales como la gestión personal de finanzas. Ni la tecnología de la pantalla ni su tamaño eran adecuados para su popularización como dispositivo de lectura. Los usuarios de PDA adquirimos nuestros cacharritos antes por las características de la plataforma en sí, por la idea, que por un uso claro y específico.

De momento le está ocurriendo algo parecido a los Tablet PC, y encima a menor escala. Si habéis estado recientemente en reuniones de cierto nivel, habréis visto como cuando era oportuno salían a relucir preciosos juguetes, digo portátiles, como los Qosmio o sus primos pequeñitos, los VAIO tx. En mis reuniones, el único Tablet presente era mi fiel Toshiba Portégé M200, y eso que es más barato que los dos ejemplos anteriores y permite más posibilidades.

En su momento, lo que me enamoró de Tablet PC fue un concepto y no un uso específico y rupturista. Me cautivó el concepto de pen computing más allá de los límites de las PDA, la posibilidad de usar un formato vertical u horizontal de pantalla y manipularla con mis manos, la multiplicación por dos de mis posibilidades de interacción con la máquina (teclado y ratón + lápiz y voz). Quería el concepto, no un uso específico, y me sabía a medio camino entre innovador y early adopter en el contexto español. Sólo la firme apuesta de Microsoft me hace confiar en que no he apostado, a mi vez, por un caballo sin fuelle, que se va a quedar a mitad de camino.

En su momento, lo que me enamoró de Tablet PC fue un concepto y no un uso específico y rupturista. Me cautivó el concepto de pen computing más allá de los límites de las PDA, la posibilidad de usar un formato vertical u horizontal de pantalla y manipularla con mis manos, la multiplicación por dos de mis posibilidades de interacción con la máquina (teclado y ratón + lápiz y voz). Quería el concepto, no un uso específico, y me sabía a medio camino entre innovador y early adopter en el contexto español. Sólo la firme apuesta de Microsoft me hace confiar en que no he apostado, a mi vez, por un caballo sin fuelle, que se va a quedar a mitad de camino.Como yo, otros early adopters se preguntan por la killer application que va a lanzar a la popularidad a sus cacharros queridos. En el caso de Tablet, una killer application sería tanto un tipo de soft preexistente dramáticamente mejorado por medio de la tinta electrónica (mindmanager, por ejemplo, está en buen camino), como un tipo de producto completamente nuevo (Onenote sería el mejor ejemplo de esto, y es posible que las mejoras que van a introducir en Office 12 para él terminen de catapultarlo).

JKontheRun tampoco encuentra una respuesta definitiva a esto. Y puestos a ser futurólogo me apunto a su carro, a una apuesta que tiene desde hace años y con la que coincido desde que conocí la existencia de OQO en 2002. Así

Maybe the killer Tablet PC app is not a program at all. Perhaps we should be discussing what the killer "feature" for Tablet PCs might be.En otras palabras, quizás el salto a las manos de una "mayoría temprana" esté, precisamente, en un formato mini, en los modelos de handtop que intel prepara para el año que viene. Una máquina poco más pesada que una PDA y que arranca igual de rápido, pero con una superficie real de pantalla más decente y toda la potencia de un PC. Una máquina que pueda sostener con comodidad con una mano pero que no se me quede corta.

Hay algunos que pretenden enterrar a Tablet PC. Si algunos usuarios de Tablet no estamos equivocados, los rumores de su muerte fueron precipitados.

viernes, noviembre 11, 2005

web 1.0, web 2.0 y sociología

La parte negra: mi "primo" profesional, el sociólogo/opinólogo. El que habla de todo lo divino y lo humano. El que habla, y habla, y habla, y habla, y habla, y habla, y habla, y habla, y habla, y habla, y habla, y habla,... como el conejito de duracell, solo que sus pilas son su sueldo de funcionario y/o su red social que le engancha perennemente a diversas tertulias mediáticas o puesto avanzado (por decir algo) de comentarista social. Sí, ése que es capaz de decir cualquier cosa, y cuanto más epatante, mejor. Ese que para explicar las realidades sociológicas de Internet deja con la boca abierta a sus (incautos) alumnos, diciendo cualquier barbaridad sobre los cyborgs mientras pone diapos con capturas de páginas warras.

El problema era de origen: ni les gustaba ni les gusta el ordenador. Pillaban todo tarde, cuando llegaba el buzzword específico a los media, y lo pillaban regurgitado de los media en vez de experimentarlo directamente. Seguían viviendo no sólo de, sino en los media: a su ritmo, a un ritmo varias veces inferior al de Internet. Y el gap ha seguido aumentando desde que el primero de mis primos, allá por el 99, habló tímidamente de esa novedad(XDXD) de los chats.

En el mundo real, fuera de sus auditorios cautivos, a mis primos casi nadie les toma en serio. El cachondeillo es el tono general, y no sin razón. Lo malo es que son los miembros más visibles del gremio, y contaminan la imagen de la profesión.

Como siguen leyendo sus periódicos y viendo sus programitas de la 2 para entender Internet, van a seguir hablando del jodío Cyborg durante unos años más. Cada vez más en el vacío. Cada vez más entre ellos. Mientras, el mundo real sigue girando a una velocidad cada vez mayor.

Por cierto, no hablo de los sociólogos. Hablo de esos sociólogos. Sí, ellos saben de quién hablo... saludetesss XDXDXD

jueves, noviembre 10, 2005

La cosa 2.0 y Bill Gates: vienen cambios

El resto es historia. A la luz de lo ocurrido, es evidente que Microsoft se estaba tomando completamente en serio una amenaza no contra su posición de dominio, sino contra su mera supervivencia. Otra cosa es lo que los tribunales estadounidenses determinaron como prácticas contra la competencia.El crecimiento de la Internet ha sido impulsado por el éxito de una serie de 'plataformas' que [...] ofrecen una serie de APIs a los ISV para que desarrollen sobre ellos. Con mucho, la plataforma más exitosa hasta la fecha ha sido Netscape, con Navigator como navegador y Suite Spot en el servidor. La amenaza crítica para Microsoft reside en el potencial que tiene esta plataforma para abstraer la API Win32. Por ejemplo, si Netscape sigue logrando que más y más ISV desarrollen aplicaciones para sus APIs cliente/servidor, estas APIs terminarían por ser las más relevantes del mercado, poniendo en cuestión a Win32.

Hace dos días llegó a Associated Press un email de contenido comparable al del 26 de Mayo de 1995 (Fuentes: Breitbart, Businessweek). En él, el chairman de Microsoft urgía a los directivos de su empresa a "actuar rápida y decisivamente" para lograr mayores avances en los productos de software y servicios basados en Internet, para "lograr el predominio sobre competidores formidables". Y no dejó de advertir que la compañía "debe ser juiciosa a la hora de definir la tecnología adecuada que sirva a la audiencia adecuada". "Esta ola de servicios va a ser muy disruptiva".

"Gates comparó el ímpetu con el que está llegando esta ola de servicios con los cambios que vivió hace una década". "Tenemos el cambio encima".

Al igual que en 1995, Microsoft se ha apresurado a ofrecer un rango de productos comparable al de la amenazadora competencia. Estas comparaciones que hace el propio Gates me llevan a pensar que lo que no está en peligro es la supremacía, sino la supervivencia de la Microsoft que conocemos. En aquella época, el timing fue perfecto y la oferta inicial del IE y su integración posterior en Windows98 decidió drásticamente lo que acabó siendo un juego de suma cero.

Este escenario no parece fácil que se repita.

Pero todos los que se están lanzando a la arena de la nueva generación de aplicaciones y servicios que me resisto a dejar de llamar web 2.0, están jugando desde unas premisas muy semejantes a las de Netscape en su día: centrarse en el navegador y no en el sistema operativo.

El año que viene sale Windows Vista.

Cuando el río suena, agua lleva: parece que esto de la cosa 2.0 no va a ser humo.

¿O sí?

miércoles, noviembre 09, 2005

algunas reflexiones sobre el laptop de 100$ de Negroponte

Me apetece hablar del tema después de que sea noticia y antes de que vuelva a serlo en Túnez el 17 de noviembre: World Summit on the Information Society. En este encuentro veremos el primer prototipo del mayor proyecto para superar la brecha digital propuesto hasta hoy. Para los que no lo conozcáis, ésta es su web y en consumer han publicado una clara infografía al respecto. Pangea nos ofrece otro interesante artículo de fondo sobre la cuestión.

Me apetece hablar del tema después de que sea noticia y antes de que vuelva a serlo en Túnez el 17 de noviembre: World Summit on the Information Society. En este encuentro veremos el primer prototipo del mayor proyecto para superar la brecha digital propuesto hasta hoy. Para los que no lo conozcáis, ésta es su web y en consumer han publicado una clara infografía al respecto. Pangea nos ofrece otro interesante artículo de fondo sobre la cuestión.Para empezar, el nombre correcto del proyecto: One Laptop Per Child, OPLC. Apunta muy eficientemente al objetivo del proyecto: que los niños de los países en vías de desarrollo sean mañana adultos en el lado bueno de la brecha digital.

La barrera técnica más importante es, probablemente, la pantalla. Por diferentes motivos, el modelo final debería estar basado en e-ink (un ejemplo real, el sony librié). Sin embargo, el refresco de estos displays no es todavía lo suficientemente rápido, por lo que parece que se optará por una pantalla LCD que sacrificará claridad de imagen a cambio de consumo de energía. Aquí tenemos una buena referencia a esta cuestión y otras relacionadas con OPLC, si bien aquí afirman que e-ink proporcionará un display derivado de sus tecnologías de tinta electrónica.

Otro aspecto que queda sin resolver es la reacción de la industria: si se puede llegar a vender un portátil (sin beneficios, dicho sea de paso) por 100$, ¿Cómo se justificaría la política de precios actual o, lo que es peor, la potencia y características que incluyen los laptops actuales, mucho más allá de las necesidades del usuario medio? Si yo fuera uno de los vendors principales de portátiles, me cuidaría mucho de tratar de que OLPC fracasara o, si no es posible, de distinguirlo de mis productos a base de ningunear su imagen.

Estética aparte, el dispositivo es un prodigio de funcionalidad: es un laptop, un ebook, un tablet, según lo que el estudiante necesite en cada momento... y lo que marquen las necesidades culturales (p.e., para china el modo tablet presenta ciertas ventajas para introducir ideogramas). En cualquier caso, para sintetizar: disminuirían drásticamente los costes de libros, el estudiante accedería a contenidos mucho más allá de los libros de texto (e.g., wikipedia), y no sólo accedería a los contenidos educativos sino que podría participar en ellos.

Esto nos llevaría a dos límites: por un lado, la utilidad del OPLC será limitada si no se desarrolla software y contenidos localizados, adaptados a las necesidades locales. Por otro, el dispositivo es sólo una de las barreras de adaptación que han de superarse. El sistema educativo ha de integrar positivamente al OPLC + soft local formando a los profesores y dotando de mantenimiento adecuado al parque de dispositivos. De hecho, me parece razonable asumir que es imprescindible que se lleven a cabo estudios locales en profundidad antes, durante y después de la implantación de los OPLC para mejorar las posibilidades de éxito y que no se convierta en otra iniciativa de superación de la brecha digital que fracasa porque se base únicamente comprar equipos y no en adaptarse a las condiciones y necesidades locales. Ya sé que con esto barro para casa, pero creo que es de difícil discusión.

En cualquier caso, pienso que es una idea magnífica y con visos de triunfar si nadie lo impide: aún cuando su integración en el sistema y método educativo fuera lenta, las rápidas mentes de los niños podrían sacar partido a un, digamos P2P learning, en el que los niños aprenderían también por sí mismos y entre ellos a sacar partido a lo que inicialmente sería un libro electrónico, escondiendo bajo esa máscara un buen número de posibilidades diferentes para aprender a aprender.

Como a otros, me gustaría pagar 250$ por un bicho asi para mi niña dentro de 2-3 años: pagar ía el de mi nena, el de otro niño fuera de la rica Europa y el transporte de ambos. Lo que pasa es que no acabo de ver cómo encaja esto en el juego real de nuestro sistema capitalista, cómo se puede llegar a colar una iniciativa tan desequilibrante, tan ajena a los juegos y calendarios de las grandes de las TIC. Me da miedo, es demasiado bonito...

martes, noviembre 08, 2005

De contenido y visibilidad

La incursión la he hecho a partir de una interesante página sobre Evaluación de fuentes de información. Esta página contiene un total de 45 enlaces a diferentes páginas web en las que se establecen criterios de evaluación de los contenidos web y se ofrecen consejos para optimizar el impacto en un público potencial.

Algunas de estas páginas están poco actualizadas (se han quedado, efectivamente, ancladas en el siglo XX, con fecha de última modificación anterior al 2000). Sin embargo, hay otras que siguen vivitas y coleando. Un buen ejemplo lo constituye Stanford Web Credibility Research, que forma parte del Laboratorio de Tecnología Persuasiva de Stanford. Suena bien, ¿eh? Que no se vaya a pensar alguien que no se puede persuadir al personal con una página que reúna todas las cualidades. Lo que ocurre es que, quizá, nadie llegue a tu página. Porque sí, amigos, resulta que entre las 10 guidelines ofrecidas por Stanford para garantizar la credibilidad de tu página web no se encuentra la popularidad. Es decir, que no se da importancia al ranking de Google, ni al posicionamiento en los diferentes buscadores, ni a la publicidad que hagan de ti en otros sitios web, etc. En definitiva, que la credibilidad no tiene relación alguna con la visibilidad de la página. ¿No saben acaso en qué consiste el éxito de la publicidad? ¿No saben que cuantas más veces se repite una mentira (por poner un ejemplo), más verdadera es?

Pero, ojo: ¿significa esto que los de Stanford o cualquier otro no saben de estas cosas? En absoluto. De hecho, fijaos lo bien posicionados que están los tíos en el pagerank de credibility:

domingo, noviembre 06, 2005

me dejé algo clave sobre longitud y latitud

Por una parte, Luistxo ha dejado un post muy claro y completo en mapamovil.

Por otra, si tenéis instalado Google Earth, es bastante posible que encontréis el lugar que buscáis con el buscador interno, o bien moviéndoos un poco por el mapa a partir de un lugar cercano al buscado.

Encontrado lo que queréis, tenéis que pulsar en el icono de Añadir marca de lugar (o Ctrl + n) para señalar vuestro punto. Cuando esté almacenado, la solución más rápida es pulsar encima de él con el botón derecho del ratón y escoger Copiar.

Pegamos el contenido del portapapeles en cualquier editor de texto y nos sale algo así:

<?xml version="1.0" encoding="UTF-8"?>

<kml xmlns="http://earth.google.com/kml/2.0">

<Placemark>

<name>Estepona</name>

<LookAt>

<longitude>-5.163985465527095</longitude>

<latitude>36.41027791355811</latitude>

<range>16256.95624416097</range>

<tilt>4.378295292100093e-011</tilt>

<heading>-2.197704397113441</heading>

</LookAt>

<styleUrl>root://styleMaps#default+nicon=0x307+hicon=0x317</styleUrl>

<Point>

<coordinates>-5.150901372089365,36.43010141072142,0</coordinates>

</Point>

</Placemark>

</kml>

Es obvio de donde podemos sacar nuestros tags

geo:lat y geo:lon

Doble mashup: Flickr con Google maps y con Google Earth

Una de las características de muchas aplicaciones 2.0 es su interfaz simple, cuando no minimalista. La lógica está clara: ir al grano si te interesa usar lo que ofrecen. Sin embargo, a veces puedes pagar el precio de no conocer todo lo que puedes obtener.

Al grano: empezamos buscando el tag geotagged. Este tag va acompañado de otros dos tags a partir de los que se construye la geolocalización de las fotos de flickr: geo:lat=##.###### y geo:lon=##.######. Estos dos tags suministran la información que necesitan dos mashups que hacen lo mismo de distinta forma:

- Flickrfly for GoogleEarth: a partir de los tags de geolocalización, este mashup llama a Google Earth para volar hasta el lugar de la forma tan espectacular a la que Google earth nos ha acostumbrado. El creador del sitio ha aprovechado la API de Googlemaps de otras formas creativas. Para introducir una llamada a Flickrfly desde vuestra foto, sólo tenéis que introducir una línea así en el comentario de la foto:

<a href="http://www.roblog.com/flickrfly.php">Fly to this

location</a>

(Requires <a href="http://earth.google.com/">Google Earth</a>) - Geobloggers.com: el creador aprovecha la API de Googlemaps para lanzar un mapa sobre el que sitúa una versión reducida de vuestra foto. Para incluir una llamada a geobloggers desde vuestra foto, no tenéis más que introducir esta línea en el comentario de vuestras fotos:

<a href="http://www.geobloggers.com/">GeoTagged</a>

Geobloggers te ofrece un pequeño menú en el hiperenlace Toggle Commands que te permite, entre otras opciones, consultar qué otras fotos de Flickr han sido geolocalizadas con ayuda de Geobloggers.

Y por cierto: esto no tiene nada de Gran Hermano (en el sentido de Orwell): Tú decides si quieres que tus fotografías estén geolocalizadas, y cómo.

viernes, noviembre 04, 2005

tags y autoridad (intelectual)

El autor comienza comparando el filtro de autoridad para una fuente de conocimiento con los resultados de la popularización del tagging (e.g., technorati para los blogueros). Coloca, frente a frente, dos antónimos que coexisten hoy:

- una situación previa en la que los individuos confian en un sistema (académico) de asignación de autoridad y solvencia para filtrar las fuentes relevantes de cara a solventar una necesidad de información/conocimiento dada.

- una innovación sin precedentes, sólo posible por una solución tecnológica pensada de la forma adecuada: un número enorme de usuarios empleando tags continuamente para clasificar contenidos propios o ajenos. En suma, una hiperbolización de la situación de sobrecarga de información inherente a Internet.

El autor propone como solución a wikipedia, como otro hijo de la inteligencia colectiva con propósito distinto y que reúne lo mejor de los dos mundos. Si las nubes de tags permiten contemplar el alegre alboroto de la blogosfera como si fueramos Ozymandias delante de su muro de monitores, Wikipedia soluciona una parte de nuestras necesidades de información solvente merced a la autoridad que le confiere la combinación de "arquitectura de la información, diseño visual, gobierno, el propio nombre de Wikipedia, un amplio consenso sobre su honestidad intelectual y el poder de la inteligencia colectiva".

No es el recurso definitivo de información. No es perfecto. Pero en los dos últimos años no ha hecho otra cosa que mejorar.

La crítica tradicionalista hacia la wikipedia (trolls y amateurs como amenazas permanentes a la calidad de las entradas), deja a un lado la falibilidad de fuentes consolidadas y, en general, las fuentes de sesgo (subjetividad, perspectiva, intereses) presentes en toda fuente de información. Esta crítica arrecia cuanto mayor es el ritmo de cambio de las tecnologías disruptivas y, a la vez, se vislumbran amenazas para la fuente de autoridad por autonomasia: la academia.

Sin embargo, el autor termina dejándose llevar por el vértigo: atribuye la autoridad de Wikipedia, su éxito como fuente de información, a una arquitectura tradicional de la información (con convenciones de diseño muy estrictas) y a la existencia del "Consejo de sabios" con Jimbo Wales a la cabeza.

¿Arquitectura tradicional de la información? ¿Me repita? ¿De un conjunto de conocimiento orgánico articulado a partir del concepto wiki?

¿Qué sería del Board of Trustees sin los core contributors ni la legión de participantes ocasionales?

Mi desencuentro con un artículo por lo demás magnífico culmina cuando mete en liza a Google y a It's the Findability, Stupid!. ¿Qué tendrán que ver los cojones con comer trigo? ¿Cómo se justifica comparar la "encuentrabilidad" de google con un tag cloud? ¿Cómo lleva el miedo intelectual a separar a wikipedia de los tagclouds como los resultados buenos y malos del software social?

Creo que Todos los casos de software social que están madurando en estos tiempos(?) de web 2.0 responden a un patrón único: todos son efectos de la mencionada inteligencia colectiva o, si se prefiere, son sinergias inéditas, a escala mundial, posibilitadas por tecnología bienpensada

que está madurando con rapidez.

Si necesito encontrar algo con rapidez, tiro de los buscadores modernos. Si necesito un punto de partida generalmente confiable, tiro de Wikipedia. Si quiero sorpresas, tiro del hilo de un tagcloud en del.icio.us. Si quiero hacer de Ozymandias en la blogosfera, abro el tag cloud de technorati. ´

De momento puedo hacer eso, y mucho más. Antes no lo podía hacer, y mañana podré hacer cosas imprevisibles si me sirvo de los resultados de la inteligencia colectiva cuando ésta se sirve de mí.

Tengo que parar. Me ha salido un post a borbotones. Demasiadas cuestiones a la vez. Demasiada confusión al estilo web 2.0. Y puede que el tipo tenga razón.

Vía You're it

(Technorati: Tagging)

(Me da un poco de pudor, pero... marcar con del.icio.us)